Наверх

Наверх

Обзор Nvidia GeForce GTX 1080: Самая крутая графическая карта за всю историю

«Это безумие», – гордо сказал CEO Nvidia Жэнь-Сунь Хуан (Jen-Hsun Huang) на презентации GeForce GTX 1080, держа саму графическую карту в руке. «1080 – это безумие. Это невероятная производительность… 1080 – новый король графики».

«Это безумие», – гордо сказал CEO Nvidia Жэнь-Сунь Хуан (Jen-Hsun Huang) на презентации GeForce GTX 1080, держа саму графическую карту в руке. «1080 – это безумие. Это невероятная производительность… 1080 – новый король графики».

И ведь он не шутил! Долгие годы постепенного развития технологий графики остались позади, и теперь перед нами действительно крутой зверь.

Приветствуйте нового короля графики!

Огромный рывок короля графики

Несмотря на все особенности GTX 1080, невероятная производительность этой карты (стартовая цена $599 или $699 в случае Nvidia Founders Edition, попавшей к нам на обзор) не является полным сюрпризом.

Проблемы в разработке графических процессоров привели к тому, что графические карты, как от AMD, так и от Nvidia долгие годы не могли преодолеть рубеж размера транзистора в 28 нанометров. Это было действительно невероятно долго для современного мира молниеносного развития технологий. Планы перехода на 20-нанометровые графические процессоры все время срывались из-за технических проблем. А это значит, что 16-нанометровые графические процессоры Pascal, которые установлены в GTX 1080 (равно как грядущие 14-нанометровые ГП Polaris от AMD), представляют собой рывок сразу на два поколения процессорных технологий вперед.

Это уже очень круто, и в теории только за счет такого перехода можно было получить огромный рост производительности. Но в Nvidia решили не останавливаться на достигнутом.

Для производства транзисторов в графических процессорах Pascal используется продвинутая технология FinFET 3D, которая была впервые применена для выпуска массовых чипов Intel Ivy Bridge для ПК. А еще GTX 1080 становится первой в мире графической картой с памятью GDDR5X – улучшенной новой версией памяти GDDR5, которая за последние пять лет стала стандартом для графических карт.

Фронтальный вид графической карты GeForce GTX 1080

В дополнение ко всему этому Nvidia инвестировала значительные средства в архитектуру Pascal как таковую. В частности, речь идет об эффективности оптимизаций, чтобы повысить тактовую частоту, одновременно снижая потребность в электропитании. Также разработчики приготовили множество дополнительных приятных моментов, на которых мы остановимся позднее – включая возможность асинхронных вычислений, которые должны помочь картам Nvidia лучше работать с DirectX 12 и оспорить это основное преимущество серии Radeon.

Да, и самое главное – все эти новые функции плюс улучшенное ПО для повышения производительности одновременно были реализованы в GTX 1080.

Примечание. Поскольку речь идет о важном обновлении графических процессоров, мы потратим на него немного больше времени, чем обычно уходит на описание технических деталей. Если вам это не интересно, можете смело переходить к рассказу о самых крупных технических находках в GTX 1080, либо еще дальше, где мы рассказываем о преимуществах для пользователя. Тесты производительности – ближе к концу материала.

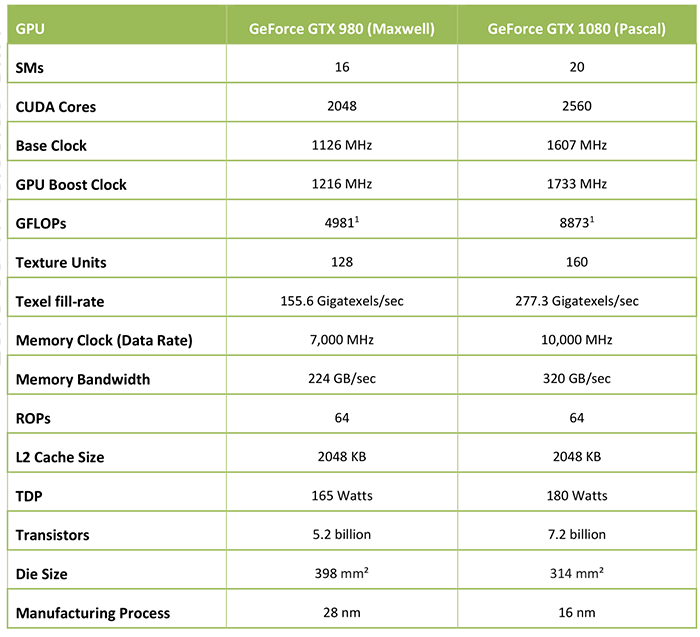

Давайте начнем со знакомства с характеристиками новинки, которые Nvidia приводит в сравнении GTX 1080 с предыдущей моделью GTX 980. Заслуживает внимания сам факт того, что компания добровольно сравнивает GTX 1080 непосредственно с GTX 980. Обычно производители графики делают сравнения графических карт с конкурентами, отстающими на два поколения. Например, в официальных материалах Nvidia GTX 960 в свое время сравнивалась с GTX 660, а не с GTX 760.

Уже здесь вы можете видеть очевидные преимущества перехода непосредственно на 16 нанометров. При том, что размер кристалла «GP104» Pascal составляет 314 мм2, что намного меньше, чем 398 мм2 у GTX 980, в нем размещено на 2 миллиарда больше транзисторов, а также на 25% больше ядер CUDA — 2 560 в GTX 1080 против 2 048 в GTX 980.

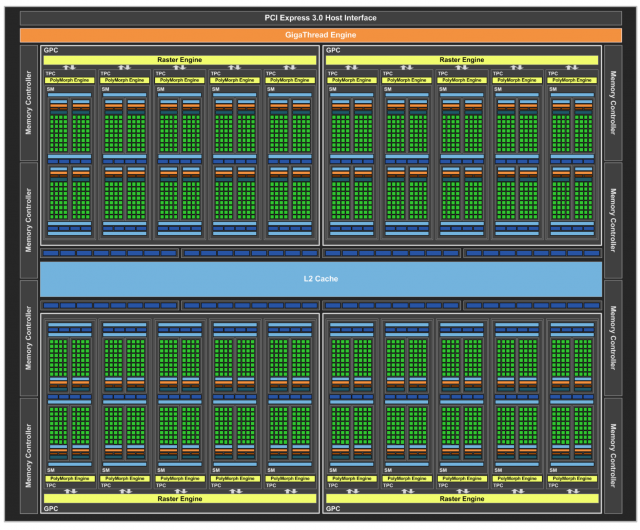

Блочная диаграмма работы поточного мультипроцессора Pascal

И верните челюсть на место! GTX 1080 действительно поражает невероятной тактовой частотой в 1 607 МГц, а также 1 733 МГц (!!!!) в режиме «boost» – и это еще только заводские скорости. Мы умудрились разогнать карту быстрее 2 ГГц при водяном охлаждении без каких-либо усилий и даже не меняя вольтаж питания. Учитывая все сказанное выше, новая графическая карта просто раздавит своих предшественников, как в играх, так и в вычислительных задачах – ведь переход от 4 981 гигафлопса в GTX 980 к 8 873 гигафлопсам в GTX 1080 – это настоящий рывок вперед.

Но идем еще дальше. Каждый поточный мультипроцессор (SM – Streaming Multiprocessor) насчитывает 128 ядер CUDA, 256 Кб регистровой памяти, 96 Кб общей памяти, 48 Кб кэша L1 и 8 текстурных модулей. Каждый SM работает в паре с движком GP104 PolyMorph, который, по данным Nvidia, берет на себя обработку вершин, мозаичное представление, трансформацию демонстрационных окон, настройку атрибутов вершин, коррекцию перспективы и новые интригующие возможности технологии Simultaneous Multi-Projection (о которой мы расскажем ниже).

Группа из 5 SM/PolyMorph с отдельным растровым модулем представляет собой графический кластер (Graphics Processing Cluster – GPC), и таких GPC на карте GTX 1080 насчитывается целых 4. Графический процессор также работает с 32-битными контроллерами памяти, шиной памяти в 256 бит и общим количеством кэша L2 в 2 048 Кб, который сопровождается 64 модулями ROP.

Блочная диаграмма всего кристалла GP104 Pascal внутри GTX 1080

Все это дополняется другим технологическим прорывом графической карты Nvidia: новой памятью. Несмотря на использование такой же шины, как у предшествующей модели, в GTX 1080 им удалось увеличить общую пропускную способность памяти до 320 Гб/с вместо 224 Гб/с в GTX 980. Это стало возможным за счет установки 8 Гб новейшей памяти Micron GGDR5X, которая работает со скоростью 10 Гбит/с — на целых 3 Гбит/с больше, чем и без того быстрая память GTX 980. Насколько же это быстро в действительности? Вот что говорится в документации Nvidia GTX 1080:

«Чтобы понять, что представляет собой эта скорость в контексте, давайте задумаемся о том, что свет проходит лишь около одного дюйма за 100 пикосекунд. Схема работы GDDR5X подразумевает, что обработка бита данных происходит вдвое быстрее, так как дальше в шине появится уже новый набор значений».

Использование такой скоростной памяти потребовало от Nvidia переработать как электронные схемы графического процессора, так и изменить каналы передачи данных на графической карте между ГП и памятью согласно спецификациям нового чипа. Кстати, как заявляет Nvidia, благодаря этому получился бы выигрыш и для стандартной памяти GDDR5.

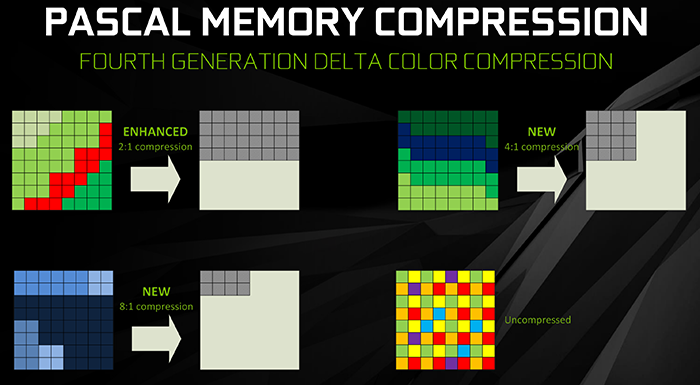

Как сжатие цвета в GTX 1080 снижает требования к пропускной способности памяти

Но Pascal имеет даже большие возможности для передачи данных, благодаря улучшенным алгоритмам сжатия памяти. Если быть точнее, процессор работает с уже используемой сегодня технологией сжатия Delta, которая встречается в графических картах Maxwell. Она снижает требования к пропускной способности памяти благодаря группировке сходных цветов вместе. Вот как эта технология описана в документах Nvidia:

«Благодаря сжатию цветов Delta графический процессор рассчитывает отличия цветов в блоке и хранит его как набор референсных пикселей плюс величина отклонения от среднего цвета. И поскольку отличия оказываются небольшими, для их хранения нужно всего несколько битов. И если сжатый блок референсных значений + отклонений оказывается меньше, чем половина несжатых данных, значит технология сжатия цвета по отклонениям работает успешно и показывает двукратное улучшение (сжатие 2:1)».

Новые графические процессоры Pascal более эффективно работают со сжатием в режиме 2:1, впрочем, для них также добавлены режимы 4:1 и 8:1, когда вариации цветов между пикселями минимальны – например, при визуализации ночного неба. Но это только возможные преимущества, так как сжатие должно происходить без потерь. Ведь геймеры и разработчики будут очень недовольны, если карты GeForce начнут портить качество картинки.

Впрочем, использование технологий сжатия цвета для того, чтобы снизить потребность в ресурсах памяти, – это совершено не новое явление. Графические процессоры AMD Radeon также используют подобные методы. Но Nvidia заявляет, что за счет этого нового, более эффективного способа сжатия, а также преимуществ самой памяти GDDR5X, GTX 1080 обеспечивает общий рост эффективной пропускной способности памяти в 1,7 раза по сравнению с GTX 980. И дело совсем не в том, что карта устарела, просто ей не хватает революционной высокопроизводительной памяти, которая впервые появилась в моделях AMD Radeon Fury, впрочем, только с ограниченной емкостью в 4 Гб.

Технологические улучшения графического процессора Pascal вместе с переходом на техпроцесс 16 нм FinFET также сделали карту невероятно энергоэффективной. Несмотря на очевидные преимущества перед Titan X, GTX 1080 потребляет всего 180 Вт мощности через один 8-контактный коннектор. Для сравнения: GTX 980 Ti высасывает из системы 250 Вт через два коннектора – 6-контактный и 8-контактный,а Fury X потребляет 275 Вт через два 8-контактных коннектора. Так что GTX 1080 дает намного больше производительности при намного меньших энергозатратах.

GTX 1080 дает ответ асинхронным вычислениям в чипах AMD

Карты AMD Radeon удерживают пальму первенства, когда речь идет об играх, использующих новейшую графическую технологию Microsoft DirectX 12, благодаря асинхронным вычислительным модулям.

Данное оборудование позволяет легко запускать несколько задач одновременно. Асинхронные шейдеры не давали особого преимущества в играх, использующих DirectX 11, потому что эта библиотека запускает задачи в основном в линейной последовательности. Но некоторые приложения под DX12 уже могут получить значительный прирост производительности – вы сможете сами это увидеть в тесте Ashes of the Singularity. Также появляется серьезное отличие при использовании асинхронного сжатия времени, технологии Oculus Rift, которая исключает появление артефактов в случае каких-либо задержек при обработке данных.

Карты на базе Nvidia Maxwell – GeForce 900-й серии – не обладают аппаратным решение такого уровня. Вместо этого они используют программную систему, которая позволяет ГП поставить задачу на паузу, чтобы выполнить более критичную, а потом – переключиться обратно на исходную задачу (принцип светофора). Да, принцип ожидания Maxwell позволяет выполнить задачи быстрее, но он не идет в сравнение с аппаратными возможностями AMD (больше похожими на многорядную развязку).

Тем временем графические процессоры Pascal демонстрируют несколько новых программных и аппаратных возможностей, которые используют технологии асинхронных вычислений. Впрочем, ни одна из них не работает в точности так же, как технологии Radeon.

GeForce GTX 1080 добавляет гибкости в процесс исполнения задач благодаря динамической балансировке нагрузки – новой аппаратной функции, которая помогает разделять задачи «на лету», чтобы ресурсы не простаивали в ожидании.

Техники статического разделения, использованные во всех предыдущих поколениях карт GeForce, подразумевали выделение определенной части ресурсов ГП для каждой из задач – например, 50% на вычисления PhysX и 50% на графику. Но если графическая задача выполнялась раньше, 50% ресурсов простаивали, пока вычислительная задача не будет также решена. Новая система динамической балансировки Pascal позволяет размещать незавершенные задачи на освободившихся ресурсах графического процессора. То есть задача PhysX из рассмотренного примера получила бы доступ ко всем ресурсам, когда расчеты графики были бы завершены. Таким образом, расчеты PhysX завершились бы раньше, чем при использовании старой схемы разделения.

Демонстрация движения жидкости на Nvidia GTX 1080 Editors Day показала результат в 78 кадров в секунду при отключенной функции, но смогла достичь 94 кадров в секунду, когда ее включили.

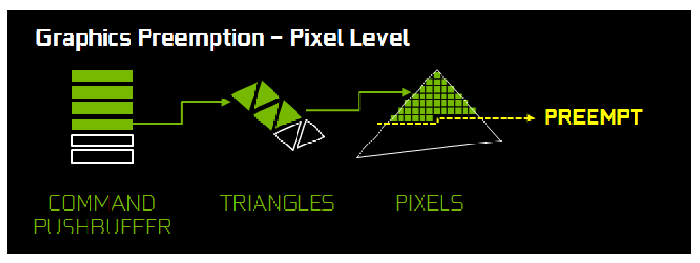

Графический процессор Pascal также использует «Вытеснение на уровне пикселя» (Pixel level pre-emption) и «Вытеснение на уровне потока» (Thread level pre-emption), дополняя комплект асинхронных решений. Они были разработаны, чтобы снизить обратные эффекты переключения между задачами на лету, когда нагрузки критически важных процессов (таких как асинхронное сжатие времени Oculus) требуют большого внимания.

Ранее вытеснение происходило на достаточно высоком уровне вычислений – между командами рендеринга от самого движка игры. Но каждая команда рендеринга может состоять из сотен отдельных вызовов буфера, а в каждом из них, по словам Nvidia, могут содержаться сотни треугольников, когда каждый из них может состоять из сотен пикселей, требующих рендеринга. Выполнение всей этой работы перед вытеснением действительно удлиняет время ожидания (относительно, конечно).

Вытеснение на уровне пикселя, которое достигается за счет совмещения программных и аппаратных технологий, по словам Nvidia, позволяет процессорам Pascal сохранить текущую нагрузку на уровне пикселя вместо завершения большой команды рендеринга, и переключиться на более критичную задачу (например, асинхронное сжатие времени), а потом – продолжить ровно в том месте, где был оставлен процесс. Это дает GTX 1080 заменять задачи быстро, минимизируя задержки. По данным Nvidia, вытеснение на уровне пикселей требует всего 100 микросекунд, чтобы приступить к новой задаче. Что же, мы поговорим о реальных результатах использования новых технологий асинхронных вычислений Pascal, когда речь дойдет до тестов DirectX 12 в игре Ashes of the Singularity. (Спойлер: результаты впечатляют!)

Вытеснение на уровне потока будет доступно позже этим летом и будет работать аналогичным образом, но с вычислительными задачами на CUDA вместо графических команд.

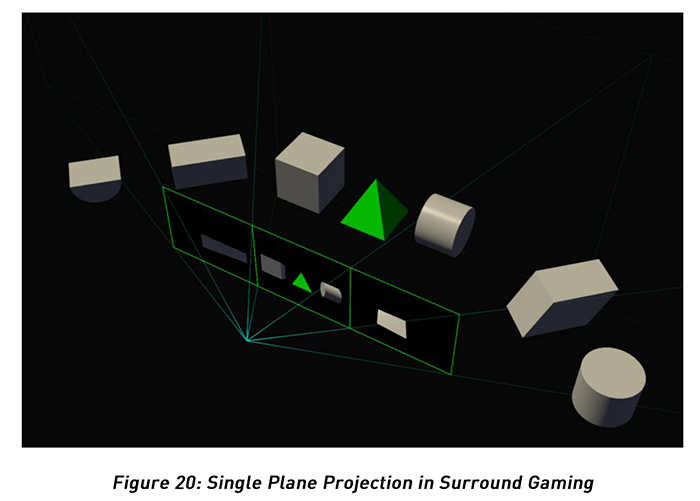

Одномоментная мультипроекция

Одномоментная мультипроекция (SMP) – действительно интригующая новая технология, когда игре нужно провести рендеринг для нескольких точек обзора в одной сцене, например, в многоэкранной установке или в двух дисплеях в шлеме виртуальной реальности. Более гранулярное использование функции SMP также позволяет повысить частоту кадров в секунду для игр на стандартных дисплеях, благодаря проведению подготовительной работы для функции шейдинга с разным разрешением (Multi-Resolution Shading), которая уже доступна даже на чипах Nvidia Maxwell.

И именно эта технология позволяет Nvidia заявлять, что GeForce GTX 1080 будет быстрее, чем две карты GTX 980 в режиме SLI. Нет, карте, конечно, не удастся показать столь впечатляющий результат в большинстве традиционных игровых тестов, но в некоторых новых приложениях она действительно оказывается чертовски близка к этому. Впрочем, сохраняется и теоретическая возможность для приложений виртуальной реальности (VR), в которых изначально заложена возможность получения преимуществ от SMP за счет использования отдельных аппаратных модулей внутри Pascal PolyMorph.

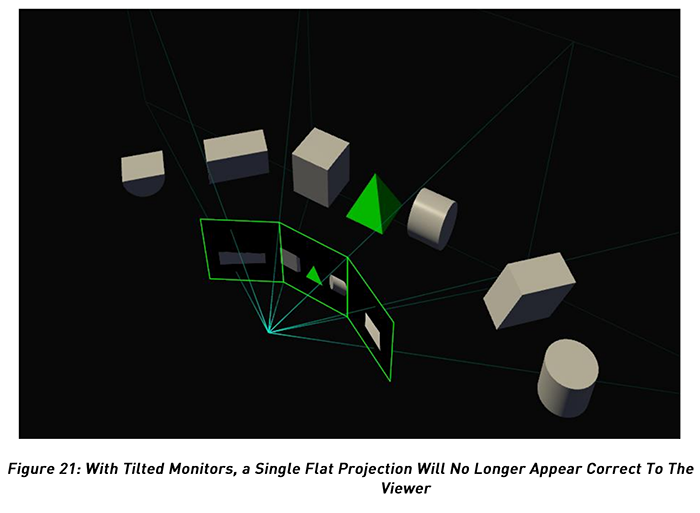

Демонстрация изображения на нескольких дисплеях традиционно требует определенного компромисса. В двухдисплейных приложениях VR каждая сцена должна быть полностью геометрически пересчитана дважды – по одному разу для каждого глаза. В многоэкранных установках, с другой стороны, требуется разделение изображения на периферийные участки, так как пользователь смотрит на них под разным углом – как показано на изображении выше. Это похоже на прямую линию, которая разделяет лист бумаги: если вы согнете его по этой линии, изображение будет расположено уже под углом, а не прямо.

Одномоментная мультипроекция разделяет геометрическую часть и часть рендеринга, чтобы решить сразу две задачи. Процессор Pascal просчитывает геометрию сцены только один раз, а потом рисует изображение для каждой точки обзора – до 16 вариантов. Эту технологию Nvidia называет «Стерео в один проход» (Single-Pass Stereo). И любые части сцены, которые не попадают в зону обзора, просто не проходят рендеринг.

Настройка Perspective Surround помогает корректно провести рендеринг для многоэкранных инсталляций

Если же вы используете SMP с несколькими мониторами, а не со шлемом VR, новая опция Perspective Surround в панели управления Nvidia позволит вам настроить вывод согласно необходимым требованиям. И прямые линии в играх уже не будут выглядеть наклонными, так как рендеринг будет происходить точно по замыслу создателей. Это приятно!

Но и это еще не все, на что способна одномоментная мульти-проекция. Существует еще техника под названием «Шейдинг для линз» (Lens-Matched Shading), которая работает на базе технологии Maxwell Multi-Res Shading. Она предварительно искажает готовое изображение, чтобы оно подходило для демонстрации через изогнутые линзы шлемов VR. При этом рендеринг краев сцены происходит при меньшем разрешении, что разумнее, чем полнопроходная обработка, которую никто не заметит. Как и «стерео в один проход» в SMP, данная идея подразумевает рендеринг только той части изображения, которую пользователь действительно увидит, а это приводит к повышению эффективности процесса.

Демонстрация Obduction – как одномоментная мультипроекция помогает повысить частоту кадров в обычной игре

Интересно, что шейдинг для линз может быть использован также для повышения общей частоты кадров даже в традиционных инсталляциях с одним дисплеем. Демонстрация Obduction с одним экраном основана на Cyan Worlds – преемнике игры Myst. Количество кадров в секунду достигало 42 при отключенной SMP и с разрешением 4K. Включение SMP привело к скачку производительности до 60 кадров в секунду – максимально доступных для дисплея, при том, что вы можете заметить лишь некоторое снижение четкости пикселей по краям экрана, да и то если стоите неподвижно и просто выискиваете артефакты.

Таким образом, одномоментная мультипроекция представляет собой удивительную технологию с большим потенциалом. Но ее основная проблема заключается в том, что разработчики игр должны обеспечить ее поддержку, при том, что она работает только на картах GeForce с графическими процессорами Pascal. Да, это убийственный аргумент для покупки GTX 1080, но будут ли игры поддерживать эту функцию, которой нет ни на одной другой продаваемой сегодня карте – большой вопрос.

Ansel: футуристический «скриншот»

Продолжая разговор об особенностях новой карты Nvidia, стоит отметить технологию Ansel, которую в Nvidia называют «3D-камера в игре». Впрочем, мы придумали ей название «футуристический скриншот».

Вместо того, чтобы просто сделать плоский снимок – как при нажатии клавиши F12 в Steam, Ansel позволяет вам поставить игру на паузу и провести съемку, перемещаясь в окружающей среде в режиме «свободной камеры» (хотя разработчики могут заблокировать функцию перемещения в своей игре). Вы можете применить разные фильтры и эффекты, как показано на изображении ниже, а также довести разрешение до невероятных параметров. Nvidia планирует создать больше фильтров со временем, а также предлагает специальный API для постпроцессинга, чтобы разработчики могли создавать свои фильтры.

В демонстрации Ansel для игры The Witness мы смогли поднять разрешение до 61440 x 34560. К слову сказать, да, этот инструмент поддерживает изображения с разрешением до 4,5 гигапикселя.

Nvidia Ansel позволяет запечатлеть действительно запоминающийся момент в видеоигре

Чтобы создать такой шедевр, как показано выше, Ansel несколько минут собирал воедино достаточно большие файлы. К слову сказать, Ansel делает до 3 600 изображений меньшего размера, чтобы создать подобную сцену – включая панорамы 360 градусов, которые можно смотреть через шлем VR или просто в Google Cardboard – и обрабатывает их при помощи специальных технологий на базе CUDA, чтобы сформировать чистую финальную картинку, которой уже не нужна будет дополнительная коррекция освещения или доработка тонов. Также инструмент может сохранять файлы в формате RAW или EXR, извлекая их прямо из игр и создавая нечто вроде записи HDR.

Ansel – это инструмент, работающий на уровне драйвера, и игры должны поддерживать его. Хорошая новость состоит в том, что для этого нужен минимум усилий – Nvidia утверждает, что поддержка Ansel в The Witness потребовала всего 40 строчек кода, а интеграция инструмента в Witcher 3 – 150 строчек. Компания также планирует предложить Ansel для карт GeForce 700-й и 900-й серий на базе Maxwell. Так что мы ожидаем поддержки инструмента в играх The Division, The Witness, Lawbreakers, Witcher 3, Paragon, Unreal Tournament, Obduction, No Man’s Sky, и Fortnite в ближайшие месяцы.

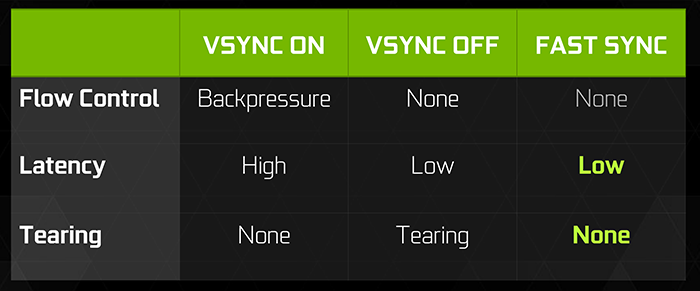

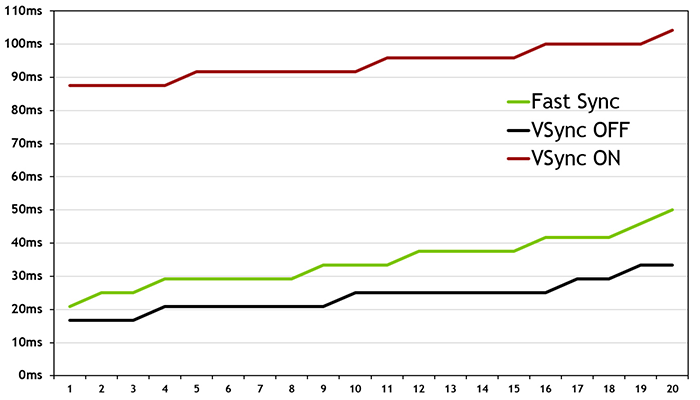

Как Fast Sync помогает справиться с задержками и дерганием

Впрочем, у GeForce GTX 1080 есть одна большая проблема: эта карта слишком быстрая, по крайней мере, для популярных киберспортивных игр со скромными требованиями к графике. Запуск Counter-Strike: Global Offensive, League of Legends, или Dota 2 на такой современной карте топового уровня приведет к частоте в сотни кадров в секунду, что намного больше, чем допустимые параметры практически любых мониторов.

Геймеры оказываются в затруднительной ситуации. Ведь такие расхождения между частотой обновления монитора и невероятным количеством кадров, которые создает графическая карта, может привести к наложениям и появлению отвратительных артефактов в результате того, что монитор показывает несколько кадров одновременно. Включение вертикальной синхронизации (V-sync) приводит к появлению задержек в игре, так как графический движок получает команду замедления. А задержка в скоростном мире онлайн-игр потенциально лишает вас важных преимуществ.

Новая функция GTX 1080 – Fast Sync – была создана для решения обеих проблем, она разделяет стадии рендеринга и отображения картинки. И поскольку вертикальная синхронизация отключена, движок создает фреймы на полной скорости – это предотвращает появление задержек. А дальше карта использует специальную логику, чтобы определить, какие фреймы нужно сканировать и показывать на экране, чтобы избежать неприятных эффектов.

Таким образом, по словам Тома Петерсона из Nvidia, лишние фреймы будут пропущены, чтобы сохранить четкость видеоряда на экране. Однако следует помнить, что Fast Sync был создан для игр, в которых частота рендеринга кадров намного превосходит частоту обновления для вашего монитора. Поэтому включение Fast Sync в играх с нормальной частотой кадров может теоретически привести к артефактам. Да, просто не делайте этого.

Результаты работы этой функции, в общем-то, впечатляющие. Ниже приведены результаты Nvidia и по измерению задержки в CS:GO.

Ожидается, что Fast Sync будет использована во множестве других карт, а не только на графике Pascal. «Поддержка [графических адаптеров] будет достаточно широкой», – сказал Петерсон.

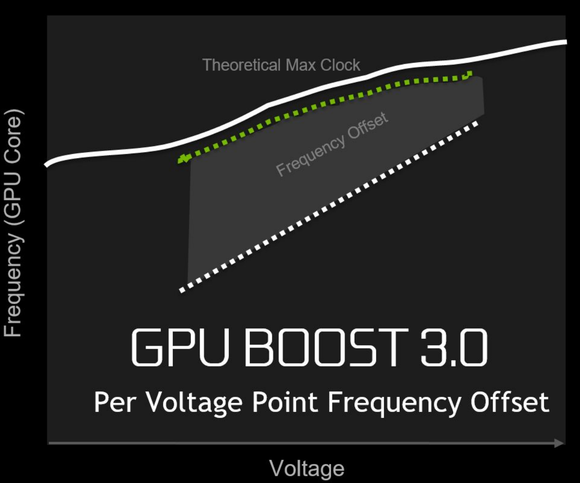

GPU Boost 3.0

Nvidia также реализовала еще одну потенциально привлекательную опцию в GTX 1080, это утилита для разгона под названием GPU Boost 3.0.

Предыдущие методы разгона по-прежнему доступны, но GPU Boost 3.0 позволяет настраивать модуляции тактовой частоты в привязке к определенным уровням напряжения, что позволяет высвободить каждый «кусочек мощности», доступный для разгона, потому что не требует использования единой частоты для всей карты. Инструменты разгона просканируют ваш графический адаптер и определят максимальную частоту для огромного количества значений напряжения питания. После этого будет построена кривая V/F, отражающая возможности вашей конкретной графической карты. Прелесть в том, что теперь ничего не нужно угадывать. Вы просто можете выставить нужный вам уровень производительности без суеты и перебора.

В свое время Nvidia предложила обозревателям раннюю версию своей новой карты EVGA Precision X с поддержкой GPU Boost 3.0, которая доказала, что с этой утилитой можно достаточно сильно расширить возможности карты. Настройки позволяют задать минимальное и максимальное смещение частоты для тестирования, а также «шаг» – то есть какие увеличения тактовой частоты будут отличать каждое следующее смещение. После того, как наша карта постоянно зависала со стандартными настройками Precision X, мы уменьшили значение шага с 12,5 МГц до 5 МГц. Система перестала перегреваться, но тест в тоге работал невероятно медленно.

Если бы у нас было время пройти полное тестирование, в результате получился бы очень гранулярный профиль разгона, составленный индивидуально для нашего графического процессора. Но поскольку утилита попала в наши руки достаточно поздно, мы задали ручные параметры теста вместе с копией бенчмарка Unigine Heaven. Результаты вы сможете найти в разделе, посвященном производительности.

Поддержка HDR и DRM

GeForce GTX 1080 продолжает традицию Nvidia по части поддержки технологий, разработанных для ПК-медиацентров. После того, как GTX 960 и 950 стали первыми серьезными картами с поддержкой HDCP 2.2 для воспроизведения защищенного авторским правом видео в формате 4K через HDMI, GTX 1080 удивляет свой поддержкой технологии HDR (High Dynamic Range). Дисплеи с HDR увеличивают яркость, чтобы создать более широкий диапазон между светом и тенью. И несмотря на то что это звучит очень просто, технология оказывает серьезное влияние на картинку. Некоторые считают, что разница между дисплеями с HDR и без HDR более ощутима, чем между дисплеями с разрешениями 4K и 1080p. Кстати, графический процессор AMD Polaris также будет поддерживать HDR.

Pascal поддерживает HDR в играх, а также кодирование и декодирование видео HEVC HDR. А совместное использование GTX 1080 (и его возможности декодирования HEVC 10b) с телевизионной консолью Nvidia Shield Android TV (и ее способностью декодировать HEVC 10b) позволяет использовать еще один интересный фокус: GameStream HDR. Говоря другими словами, вы можете просто транслировать вашу игру с компьютера, оснащенного графикой Pascal, на телевизор через Nvidia Shield. И поскольку оба устройства поддерживают HDR, вас ждут яркие и глубокие цвета в том числе и на телевизоре. Надо сказать, это весьма умный ход Nvidia по использованию возможностей экосистемы, чтобы обойти ограничение поддержки HDR только для традиционного телевидения. Впрочем, функция будет доступна не раньше конца лета этого года.

В настоящее время перечень игр с поддержкой HDR ограничивается следующими именами: Obduction, The Witness, Lawbreakers, Rise of the Tomb Raider, Paragon,The Talos Principle и Shadow Warrior 2. Однако можно рассчитывать, что таких игр будет становиться больше, по мере увеличения популярности оборудования с поддержкой технологии.

Кроме этого, графические процессоры Pascal сертифицированы для работы с Microsoft PlayReady 3.0, позволяющим показывать защищенное видео в 4K на ПК. В основном благодаря этому графические карты на базе Pascal смогут показывать поточный контент в 4K с Netflix уже в этом году. А использование видео в 4K на ПК делает осмысленной установку Windows 10 и DRM.

Набор портов Nvidia GTX 1080

Чтобы транслировать все эти новые видео, GTX 1080 обладает одним портом HDMI 2.0b, одним интерфейсом dual-link DVI-D, а также тремя полноразмерными разъемами DisplayPort, сертифицированными DP 1.2, но готовыми к работе в режимах DP 1.3 и 1.4. Это говорит о том, что карта сможет работать с 4K-мониторами на частоте в 120 Гц, 5K-мониторами на частоте 60 Гц и даже с 8K-мониторами на частоте 60 Гц – однако для последнего варианта потребуется не один кабель, а два.

Высокопроизводительные мосты SLI

Nvidia серьезно меняет модель множественной установки графических процессоров в связи с поддержкой DirectX 12. Начиная с GTX 1080 Nvidia будет предлагать специальные мосты SLI HB с высокой пропускной способностью, которые будут занимать не один, а оба порта SLI на графических картах, чтобы передать весь поток информации между ними.

Чтобы воплотить эту концепцию и снизить затраты на разработку конфигураций на 3 и 4 карты, которые мало кем используются, теперь графические карты Nvidia будут официально поддерживать только двойное соединение SLI. Подключение 3 и 4 карт также будет работать, но неофициально и при помощи специальной утилиты Nvidia, которую нужно будет загрузить отдельно.

Это важное изменение, и мы изучаем его в отдельной статье, посвященной настройкам GTX 1080 SLI.

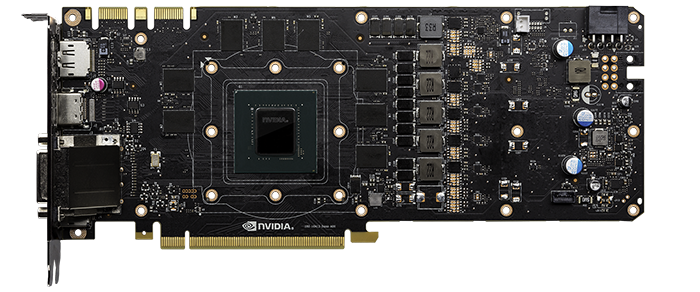

Nvidia GeForce GTX 1080 Founders Edition

Изменения в сфере SLI не имеют большого значения в нашем обзоре, так как на тест пришла только одна карта Nvidia GeForce GTX 1080 Founders Edition. И пусть вас не смущает особое название Founders Edition: это просто новая обертка для референсного дизайна. В этой карте нет ни особых возможностей разгона, ни специально отобранных процессоров. Однако есть повод для замешательства: если цена обычной GTX 1080 составляет $600, Founders Edition стоит $700.

Что же, все дело в том, что эта карта дает возможность познакомиться с новинкой раньше всех. Ведь Founders Edition – это единственная версия GTX 1080, появление которой гарантировано Nvidia уже 27 мая. Так что вы платите эту цену за то, что будете первыми.

Представленные в последнее время референсные карты Nvidia GeForce являются примерами премиальной сборки. GTX 1080 продолжает эту традицию с угловатым алюминиевым корпусом, паровой камерой, которая выдувает горячий воздух с задней стороны вашего ПК, а также низкой посадкой (часть корпуса может быть убрана для улучшения циркуляции воздуха в режиме SLI) и новинками, которые кроются внутри, – 5-фазным дизайном dual-FET и улучшенной электрической схемой. Эта карта буквально «кричит» о своем премиальном статусе и олицетворяет собой качество. Металлический корпус в форме многоугольника выглядит даже более привлекательным, чем ожидалось по ранним снимкам, которые в свое время утекли в сеть.

GTX 1080 (снизу) отличается более угловатым дизайном, чем GTX 980 (сверху). Все ребра и углы лучше видны при прямом свете

Но предыдущие референсные карты Nvidia были лишь образцами, они появлялись в продаже только за несколько недель до официального запуска на рынок новой серии графических карт. В этот раз Nvidia планирует продавать карты Founders Edition на протяжении всего жизненного цикла GTX 1080. Это позволяет покупать графику напрямую у компании Nvidia, а также дает возможность продавцам стильных систем сертифицировать единственную модель GTX 1080 для своих ПК и использовать ее на протяжении всего срока службы, не беспокоясь о том, что спецификации Nvidia или ее партнеров – EVGA, Asus, MSI или Zotac – могут измениться. На самом деле, владелец Falcon Northwest Кельт Ривс (Kelt Reeves) сказал HardOCP, что он лично активно убеждал Nvidia выпустить такие карты именно по этой причине.

Скорее всего, вы сможете найти графические карты от партнеров с мощными возможностями разгона, дополнительными коннекторами питания и специальными системами охлаждения за те же $700, что и Nvidia Founders Edition, после того, как продажи графического процессора станут массовыми. Другими словами, Founders Edition, скорее всего, не будет хорошей покупкой, если ваша цель – идеальное соотношение цена/производительность. Но зато эти $100 сверху гарантируют, что EVGA и другие не будут считать, что Nvidia решила сама с ними конкурировать. При этом создатели систем также останутся довольны.

Но довольно слов. Давайте, наконец, посмотрим, насколько в действительности крута эта карта.

Тестирование GTX 1080

Как обычно, мы тестировали GeForce GTX 1080 на нашем специальном тестовом стенде Мира ПК, который был создан для того, чтобы избежать потенциально возможных узких мест в других областях системы и показать истинную, неискаженную производительность графики. Ключевые характеристики этого стенда:

• Intel Core i7-5960X с жидкостной системой охлаждения Corsair Hydro Series H100i помогает избежать любых проблем в работе ЦП, которые могут повлиять на графические тесты

• Материнская плата Asus X99 Deluxe

• Память Corsair Vengeance LPX DDR4 memory, корпус Obsidian 750D и блок питания AX1200i мощностью 1 200 Вт

• Твердотельный диск 480 Гб Intel 730

• Windows 10 Pro

Одновременно с обновлением тестовой системы до Windows 10 мы также обновили перечень тестовых игр, обеспечив нормальный баланс приложений AMD Gaming Evolved и оптимизированных для Nvidia. Но об этом мы поговорим подробнее при обсуждении результатов тестирования.

Чтобы узнать, чего действительно стоит GTX 1080 Founders Edition, мы сравнили ее с референсной GTX 980 за $500 и MSI Radeon 390X Gaming 8GB за $460, а также с Radeon Fury X за $650 и Titan X за $1000. Поскольку производительность GTX 980 Ti очень близка Titan X – а Nvidia не рекомендует сравнивать GTX 1080 с Titan X – мы решили не проводить этот тест за отсутствием его информативности. Увы, AMD так и не прислала нам Radeon Pro Duo на тест, так что мы не можем сказать, какая из двух графических карт самая быстрая в мире – GTX 1080 или AMD с двумя процессорами Fiji.

Но можно сказать точно, что GTX 1080 нельзя ставить рядом даже с самыми мощными картами на базе одного процессора из когда-либо выпущенных. Особенно если вы разгоните ее.

Мы проигнорировали автоматические инструменты разгона в Precision X beta, так что увеличение тактовой частоты было произведено вручную на уровне 250 МГц, а скорость работы памяти была увеличена на дополнительные 100 МГц. В зависимости от того, что должно произойти в каждой сцене тестовых игр, и реакции технологии Nvidia Boost, тактовая частота варьировалась от 1 873 МГц до 2 088 МГц. Да, скорость была даже выше 2 ГГц, причем без каких-либо махинаций с питанием.

Ну а теперь – пристегнитесь! Это будет быстрая езда!

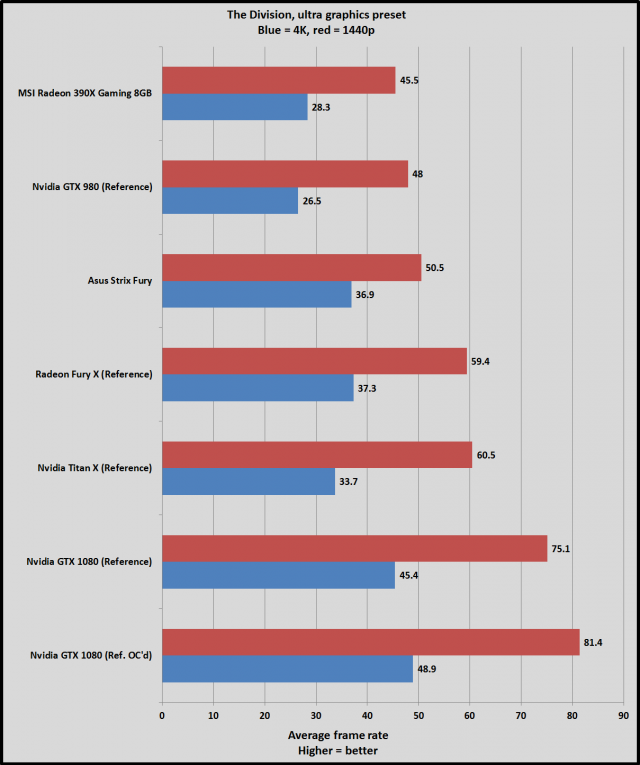

The Division

Первый тест: The Division от Ubisoft. Это шутер/RPG от третьего лица, в котором совмещаются элементы Destiny и Gears of War. В игре представлено великолепная версия постапокалиптического Нью-Йорка, анимация которого реализована на новом движке Ubisoft Snowdrop. Несмотря на интеграцию функций Nvidia Gameworks, которые мы отключили для получения честных результатов, игра прекрасно идет на любом оборудовании, и не является частью семейства Nvidia «The Way It’s Meant to be Played». Вообще она всегда лучше работала на картах Radeon.

Пока на сцене не оказалась GTX 1080.

Как вы можете видеть, референсная GTX 1080 показывает невероятный рост производительности – на 71% по сравнению с GTX 980 в разрешении 4K и с ультравысокими настройками графики. При этом GTX 1080 была разработана как смена GTX 980, а не Titan X. Кстати, GTX 1080 обходит и Titan X на 34,7% при разрешении 4K, на 24% при 1440p, несмотря на то, что она на $400 дешевле текущего флагмана Nvidia.

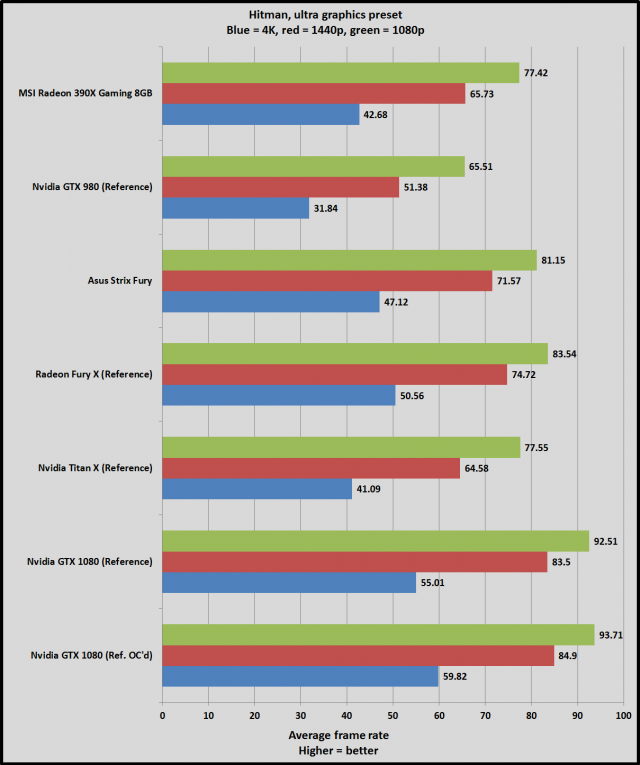

Hitman

Эта впечатляющая симуляция ремесла наемного убийцы на движке Glacier оптимизирована для AMD, и карты Radeon значительно обходят своих конкурентов из серии GeForce GTX 900, особенно на более высоких разрешениях. И хотя GTX 1080 дает значительный рывок в производительности по сравнению с GTX 980 (72,7% при разрешении 4K) и Titan X (33,8%), превосходство над Fury X оказывается намного более скромным и составляет всего 8,8% при включенном сглаживании FXAA и самых высоких настройках качества. И это напоминает нам, насколько важной может быть поддержка архитектуры на уровне движка.

Также стоит помнить, что результаты получены с использованием DirectX 11. Hitman теоретически поддерживает DirectX 12, но последнее обновление все испортило, и игра просто не запускается в режиме DX12 и на тестовом стенде PCWorld, и на наших личных компьютерах. Аминь.

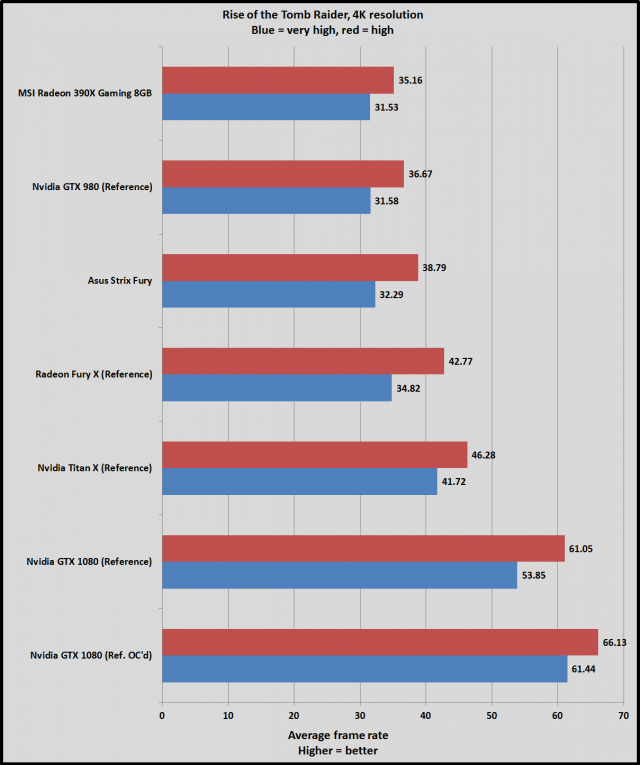

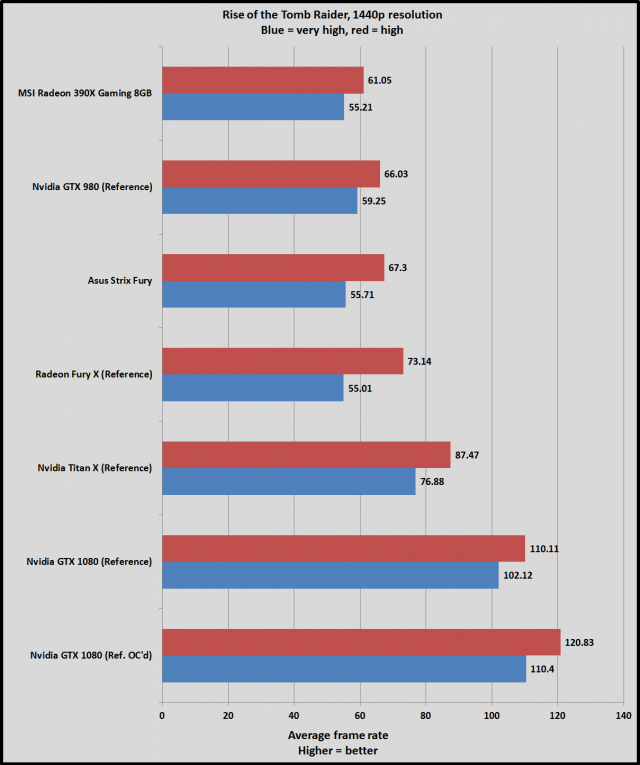

Rise of the Tomb Raider

Великолепная игра Rise of the Tomb Raider работает достаточно хорошо практически на любых графических процессорах, но все же она предпочитает карту Titan X, нежели Fury X, если говорить о топовых моделях. Однако все это теряет смысл, потому что вы получите бешеный прирост производительности с GTX 1080, особенно если ее разогнать.

GTX 1080 обеспечивает на 70,5% больше кадров, чем GTX 980 в режиме 4K при очень высоких настройках графики (Nvidia HBAO+ и AMD PureHair отключены). Разрыв увеличивается до 94,5% после разгона. Это же вдвое больше производительности!

Просто Вау!

Рост производительности по сравнению с Titan X оказывается более скромным и ограничивается 29%, которые, впрочем, увеличиваются до 47% после разгона. Поражение Fury и Fury X, скорее всего, объясняется небольшой емкостью памяти HBM в 4 Гб, ведь игра даже предупреждает, что использование очень высокого качества текстур может вызвать проблемы на картах с 4 Гб памяти или меньше.

Мы не стали использовать результаты теста производительности RoTR в DirectX 12, так как в данном режиме количество кадров в секунду постоянно падало. Но стоит отметить, что при включенном DX12 минимальное количество кадров в секунду также получило двузначный прирост в процентах. Это значит, что на DX12 игра показывает меньше кадров, но также меньше дерганий и задержек.

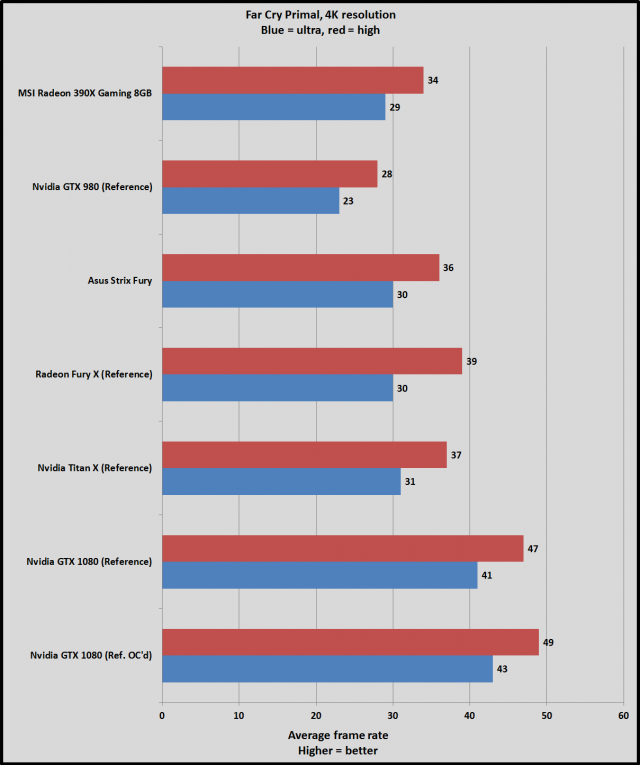

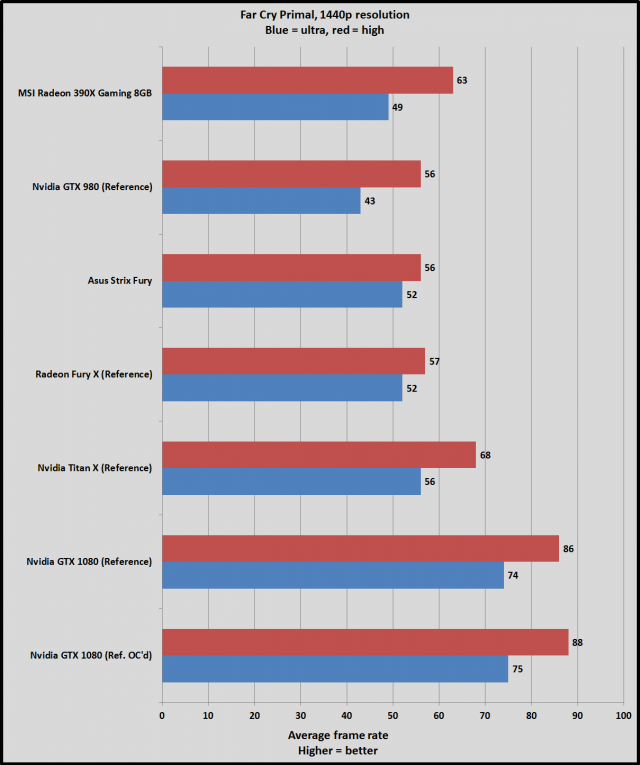

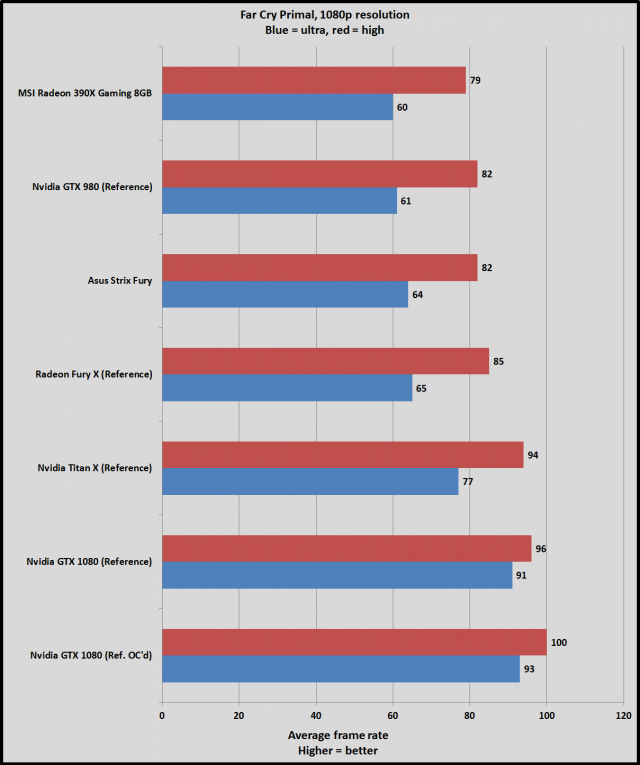

Far Cry Primal

Far Cry Primal – это еще одна игра Ubisoft, но работающая уже на новейшей версии уважаемого движка Dunia, который используется в этой серии многие годы. Мы тестировали наши карты в этой игре с подключенным комплектом «free 4K HD texture pack».

Что же, игра работает хорошо на всех картах, хотя супер-быстрая память процессоров Fiji дает картам AMD Fury конкурентное преимущество на более высоких разрешениях. Однако все меняется при меньших разрешениях. На 4K-настройках Ultra GTX 1080 показывает 78-процентный рост производительности по сравнению с GTX 980, а также 33-процентное увеличение на фоне Titan X и Fury X.

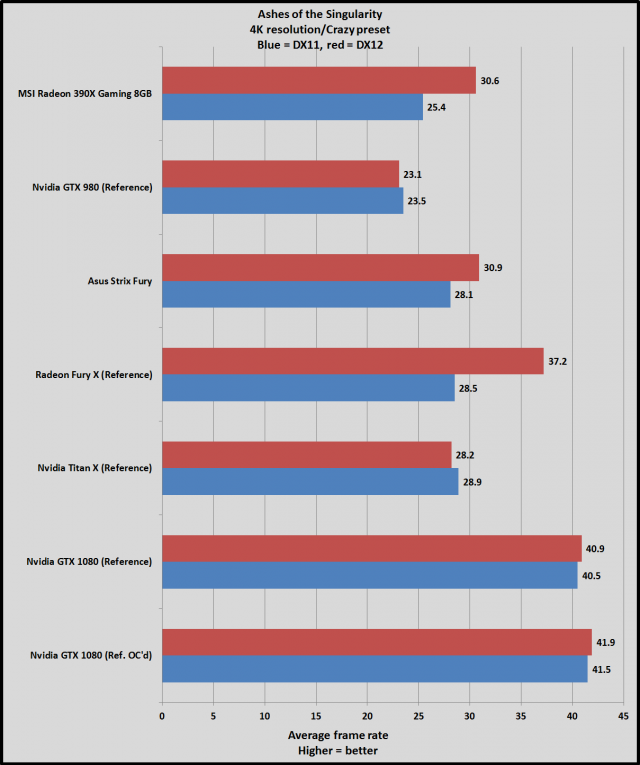

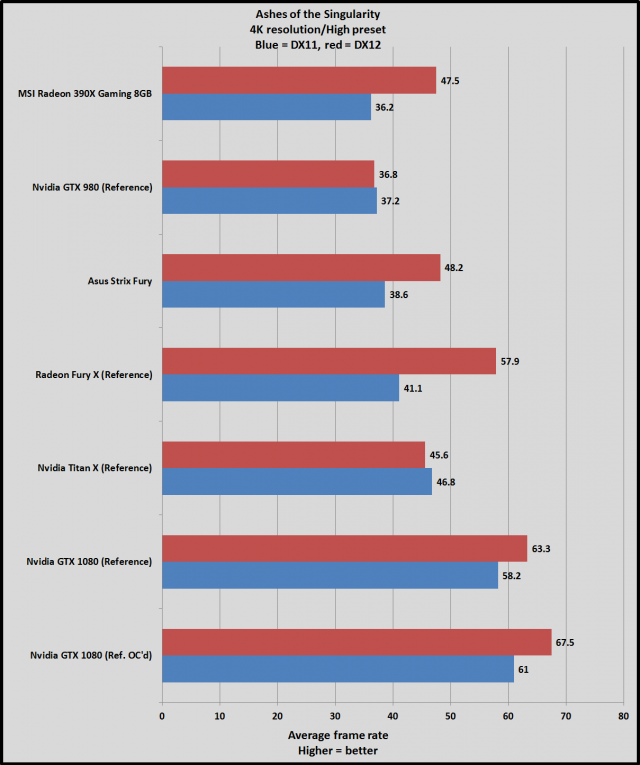

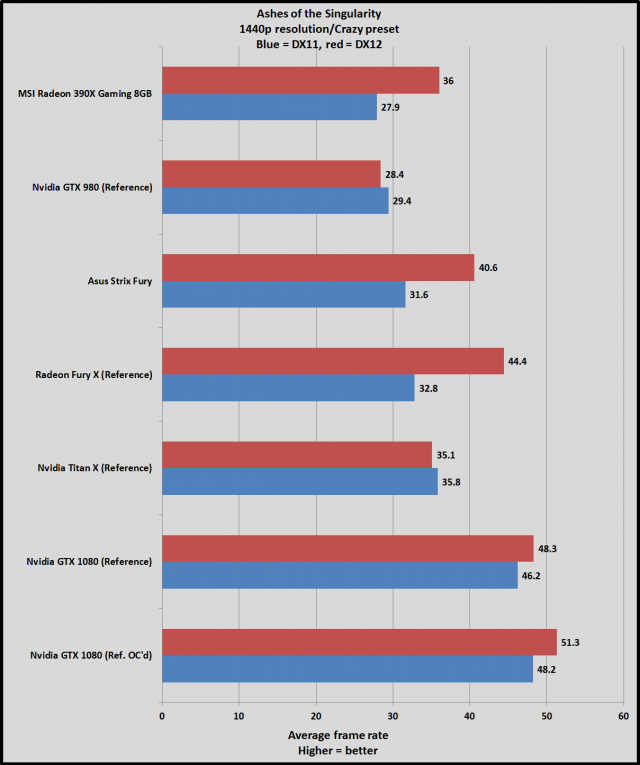

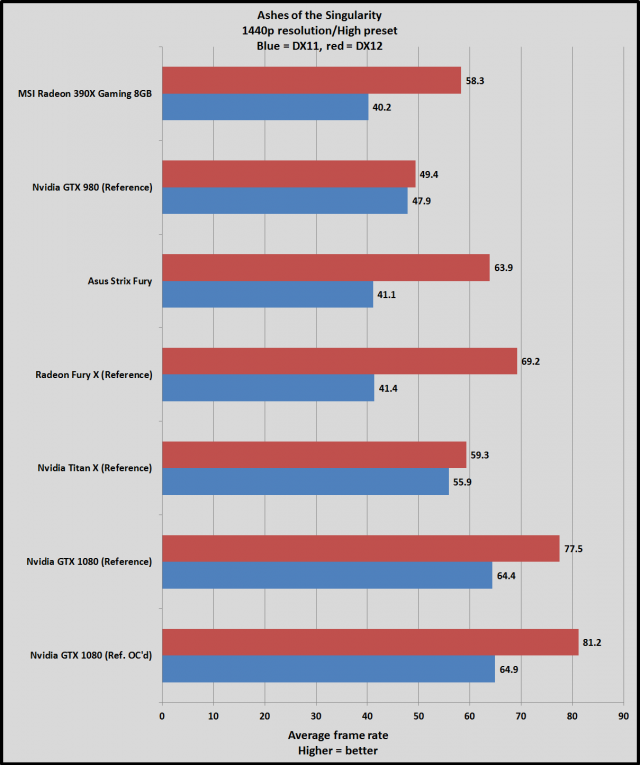

Ashes of the Singularity и DX12

Но вот, наконец, и тест GTX 1080 в DirectX 12. Библиотеку поддерживают также Hitman и Rise of the Tomb Raider, но версии этих игр для DX12 заставили нас подождать более удачных обновлений, о чем мы уже говорили ранее. При этом игры из Windows Store под DirectX 12 не подходят для тестирования из-за встроенных ограничений всех приложений Windows Store. Таким образом, под DX12 осталась только одна игра-тест Ashes of the Singularity, работающая на собственном движке Oxide Nitrous.

AoTS изначально была первым знаменосцем DirectX 12, и рост производительности в этой игре при переходе на DX12 с DX11 просто поражает – по крайней мере на картах AMD. Версия AoTS DX12 очень активно использует асинхронные технологии, которые поддерживаются на аппаратном уровне в чипах Radeon GPU, но не в картах GTX 900-й серии от Nvidia. На самом деле программное вытеснение в картах на базе Nvidia Maxwell только мешает асинхронным возможностям игры, так что программисты Oxide включили игнорирование асинхронных возможностей при обнаружении графики GeForce.

Итак, мы получили очень интересные результаты. Графические процессоры Nvidia Maxwell работают в режиме DirectX 12 даже хуже, в то время как карты AMD Radeon демонстрируют значительный рост производительности при включении DX12 – и Fury X в режиме DX12 может даже достичь и превзойти результаты референсной GTX 1080 в режиме DX11, несмотря на то, что GTX 1080 просто рвет Fury X, работающую с DX11. И для AMD это снова большая победа.

Кстати, как только вы перестаете вдавливать педаль «в пол» и уменьшаете настройки с 4K/бешеное качество, GTX 1080 начинает показывает значительный рост производительности в DX11 по сравнению с DX12, хотя ей и не достичь тех взрывов мощности, которые наблюдаются в случае карт Radeon. При разрешении 1440p/высоких настройках переход на DirectX 12 дает GTX 1080 20,3-процентный рост производительности. И несмотря на то что AoTS просто отключает базовые асинхронные вычисления на картах Nvidia, встроенные асинхронные возможности в графических процессорах Nvidia Pascal помогают получить серьезные преимущества для игр DX12, активно использующих асинхронные технологии.

Сравнивая непосредственно производительность Nvidia-к-Nvidia, отметим, что GTX 1080 демонстрирует рост частоты кадров на том же уровне, что и в других играх: приблизительно на 72% больше, чем у GTX 980, и на 35-40% больше на фоне Titan X.

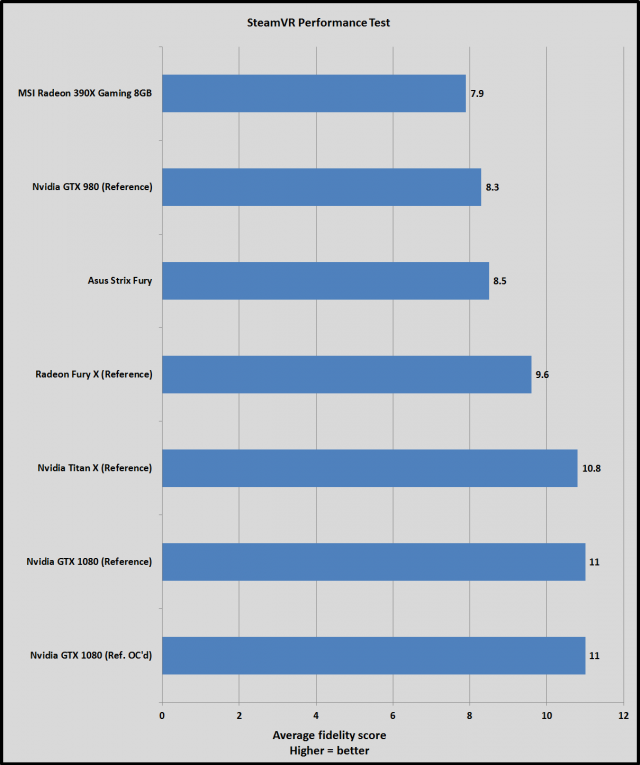

Тест SteamVR и виртуальная реальность

Самой большой неожиданностью этого обзора для нас самих стала неспособность тестов VR соответствовать графике.

Самая большая претензия Nvidia относительно производительности GTX 1080 относится именно к виртуальной реальности. И если прирост в обычных играх достаточно понятен, Nvidia заявляет, что ее новая карта будет быстрее, чем две GTX 980 в режиме SLI! 2,7-кратный рост производительности! И речь идет именно об играх VR, которые смогут полностью использовать такие программные возможности Nvidia, как одномоментная мультипроекция. К сожалению, гранулярные тесты VR от Crytek и Basemark еще не выпущены, равно как и игры VR с поддержкой новых функций GTX 1080. Таким образом, у нас просто нет возможности оценить потенциальный рост производительности GTX 1080 на фоне конкурентов, не считая теста SteamVR, который скорее подходит для того, чтобы определить, может ли вообще ваша система работать с виртуальной реальностью, а не для сравнения графических процессоров друг с другом.

Что же, в любом случае, GTX 1080 – это первая графическая карта, которая смогла получить на графическом стенде Мира ПК оценку 11 в тесте SteamVR – хотя Titan X и GTX 980 Ti были чертовски близки к этому, они не получили такой оценки.

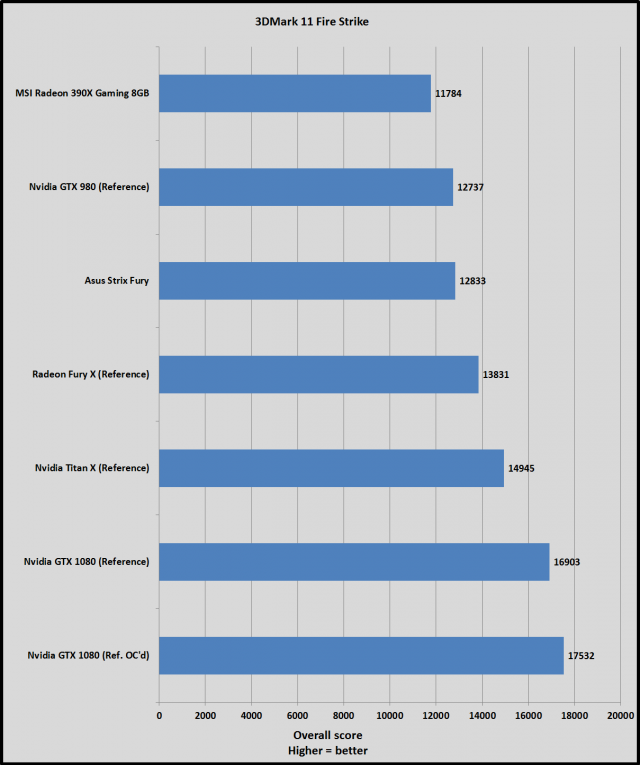

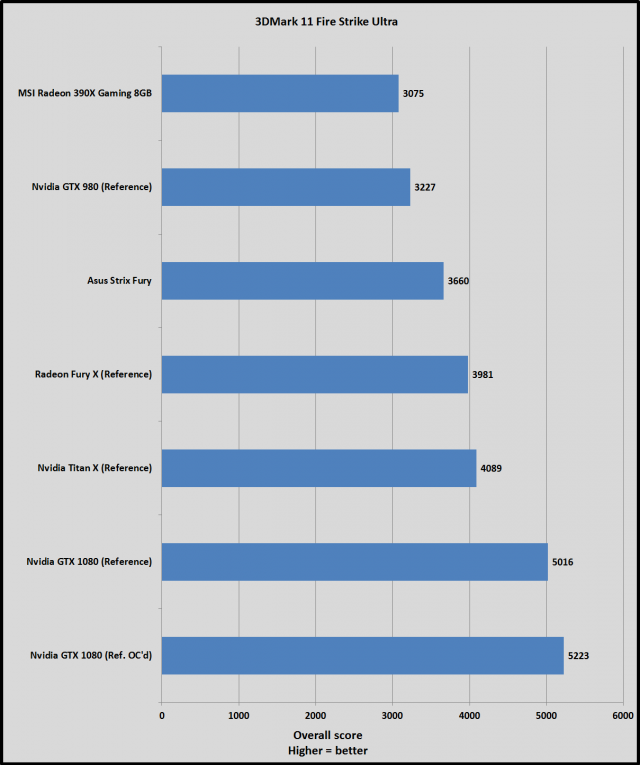

3DMark Fire Strike и Fire Strike Ultra

Мы также решили протестировать GTX 1080 при помощи уважаемых синтетических тестов 3DMark Fire Strike и Fire Strike Ultra. Fire Strike работает с разрешением 1080p, а Fire Strike Ultra обрабатывает некоторые сцены с более сложными эффектами и в разрешении 4K.

Впрочем, тут нет никаких сюрпризов, когда мы уже знаем данные из игровых тестов. Новая карта Nvidia просто «рвет» всех на каждом углу. Это первая карта, которая смогла преодолеть барьер в 5 000 очков в Fire Strike Ultra. Кстати, Fury X была единственной картой, которая смогла набрать больше 4 000, причем лишь немногим больше.

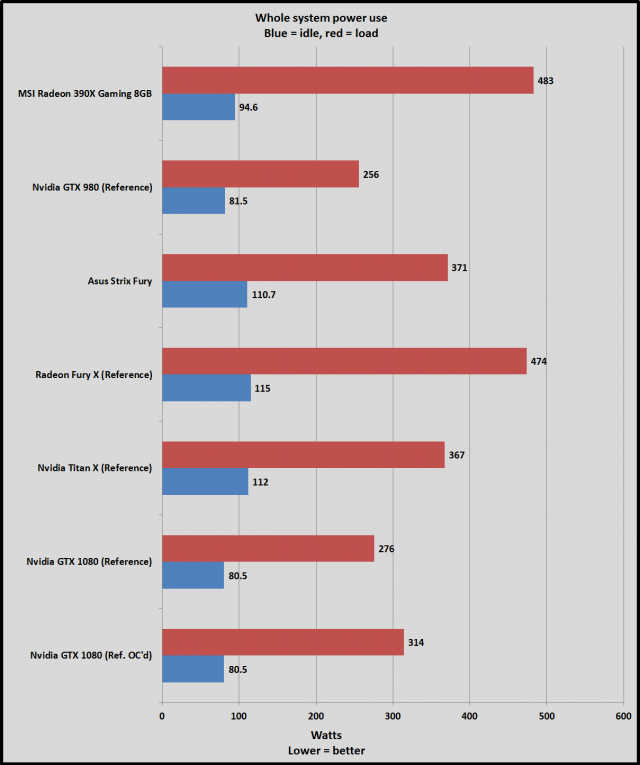

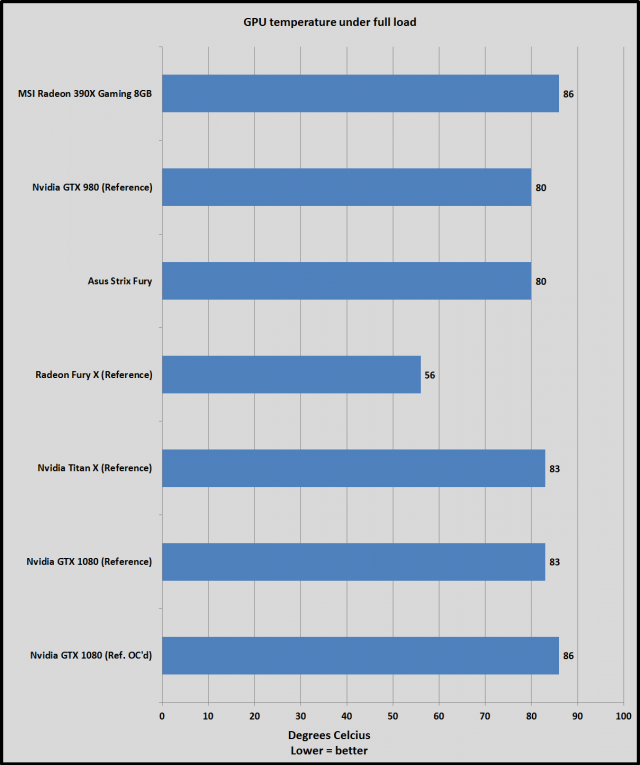

Мощность и нагрев

Наконец, давайте посмотрим на мощность и термальные характеристики GTX 1080.

Все последние графические карты AMD требовали намного больше мощности, чем их конкуренты от Nvidia. Новая GTX 1080 при этом потребляет всего на 20 Вт больше, чем GTX 980 под экстремальной нагрузкой, а также намного меньше электричества, чем горячая и прокачанная Titan X, при этом производительность новинки оказывается намного выше. Архитектура Pascal действительно энергоэффективна.

Мощность оценивалась путем подключения всей системы к ваттметру и при запуске стресс-теста Furmark в течение 15 минут. Фактически это самый худший сценарий нагрузки, который заставляет работать графику на пределе.

С другой стороны, GTX 1080 оказывается немного горячее, чем GTX 980 при максимальной нагрузке в Furmark, достигая температуры Titan X. (В этом тесте Fury X с водным охлаждением вне конкуренции.) Furmark – это действительно самый плохой сценарий, но и во время нормальной игры температура карты колеблется между 70-75 градусами по Цельсию. Впрочем, охлаждение референсной карты никогда не бывает столь же эффективно, как у карт от партнеров. Так что мы будем ожидать значительного снижения рабочей температуры у других версий этой карты.

Новый король!

Итак, мы возвращаемся к тому, с чего начали: первая и долгожданная карта Nvidia на базе графики Pascal оказалась настоящим «зверем» во всех смыслах этого слова. Она просто порвала все существовавшие рекорды, поразив при этом скромным энергопотреблением.

Ее преимущество над GTX 980 – просто невероятное! GTX 980 обходила своего предшественника GTX 780 всего на 18-35%, а новая GeForce GTX 1080 вырывается вперед на 70 с лишним процентов в каждом игровом тесте. И это просто бешеный результат. На протяжении теста мы чувствовали себя как Юрий Гагарин, который впервые вышел за пределы атмосферы и открыл новый мир, полный звезд. Уход от техпроцесса 28 нм при производстве графических процессоров оказался действительно настолько великолепным событием, насколько его представляли геймеры. Так что GTX 1080 дает нам все то, что Nvidia обещала, и даже больше.

Слава герою!

И хотя мощности новинки Nvidia все же не совсем достаточно, чтобы получить 60 кадров в секунду при разрешении 4K в любой игре, результаты Division и Far Cry Primal показывают, что она подбирается невероятно близко к этому результату – особенно если вы купите монитор с поддержкой G-Sync, который обеспечит четкий видеоряд при обновлении «почти 60» кадров в секунду. Впрочем, нельзя забывать, что последующие оптимизации движков игр могут сыграть большую роль в росте производительности, как мы видели в Hitman и AoTS, сравнивая работу карт AMD и Nvidia. Впрочем, на сегодня GTX 1080 может уничтожить любого соперника.

Не спешите преклонить колено перед новым чемпионом. Будьте терпеливы и подождите несколько недель.

AMD обещала показать свои графические процессоры Polaris в середине текущего года, и множество утечек говорит о том, что громкая презентация ждет нас на выставке Computex уже в начале июня. И намеки компании говорят о том, что начальные версии Polaris будут отличаться более доступными ценами, чем самые дорогие карты, такие как GTX 1080, но кто знает? Новые карты AMD Radeon также переходят на техпроцесс 14нм FinFET, и если у команды «красных» есть, что показать, ситуация станет еще интереснее, причем очень быстро. Например, остается вопросом, смогут ли карты Radeon остаться выше всех моделей Nvidia в вопросах асинхронной производительности с DX12.

Подождав несколько недель, мы также увидим собственные версии карт от партнеров Nvidia, и кто знает, насколько они могут оказаться быстрее? Плюс GTX 1070 также ожидается в продаже 10 июня, а Nvidia обещала для нее производительность на уровне Titan X при цене всего в $370. И это лишь пол цены GTX 1080. Учитывая, что GTX 1080 дает прирост производительности примерно на треть по сравнению с Titan X, GTX 1070 может занять позиции GTX 970, как самого лучшего решения по соотношению цена/производительность в линейке карт Nvidia. Так что, терпение, дамы и господа!

Также мы не рекомендовали владельцам GTX 980 Ti и Titan X бежать в магазин за GTX 1080. Да, новая карта Nvidia обходит даже самых тяжеловесов 900-серии, но отнюдь не «в сухую». А можете представить себе, какой поразительной мощностью будет обладать GTX 1080 Ti или Titan на базе Pascal, учитывая производительность, которую мы увидели у GTX 1080?

Впрочем, если вы не можете усидеть на месте и просто хотите GTX 1080 – это тоже неплохо. Например, Titan на базе Pascal вряд ли появится до весны 2017 года, а новый флагман Nvidia все же является лучшим образцом графической карты на сегодня. Да, GTX 1080 – это действительно крутейшая карта на рынке!